Grundlagen der digitalen Audio-Technik

Um Ihnen das Thema DAC leichter verständlich zu machen, haben wir uns zur Aufgabe gemacht, die wichtigsten Begriffe aus der Digital-Technik nachfolgend so einfach verständlich wie möglich zu erklären. Mehr geht immer, wir haben uns auf die zentralen Begriffe beschränkt.

Digital Audio repräsentiert ein analoges Audiosignal in der digitalen Domaine. Dazu gibt es diverse Methoden der Wandlung von Analog zu Digital. PCM ( Puls-Code -Modulation) ist am weitesten verbreitet.

PCM-Technologie

Die Historie der PCM-Technologie reicht erstaunlicherweise bis 1937 zurück. Der britische Wissenschaftler Alec Reeves hat das Grundprinzip dieser Technik damals entwickelt. Aufgrund der damals verfügbaren Röhren-Technologie war sie aber nicht kommerziell verwertbar. Ende der 1960er-Jahre, nachdem sich die Transistor-Technologie durchgesetzt hatte, begann die BBC und Nippon Columbia mit Versuchen, Musik digital aufzuzeichnen. Die erste digital aufgezeichnete LP wurde 1971 von Denon veröffentlicht. 1981 wurde dann auf der Berliner Funkausstellung die Compact Disc (CD) als digitaler Tonträger vorgestellt. Ende der 80er-Jahre gelangte die DAT (Digital Audio Tape) zur Marktreife, hat aber im Gegensatz zur CD den Massenmarkt nie erreicht.

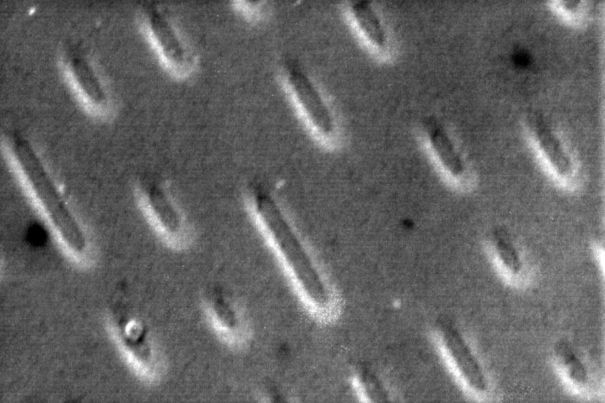

Eine CD, betrachtet unter dem Rasterelektronenmikroskop.

Eine CD, betrachtet unter dem Rasterelektronenmikroskop.Grundlagen der PCM-Analog-Digital-Wandlung

Ein analoges Signal ist Wert- und Zeit-kontinuierlich, was bedeutet, dass zu es zu jedem beliebigen Zeitpunkt jeden beliebigen Wert einnehmen kann. Dieses analoge Signal wird bei der Digitalisierung in ein Wert- und Zeit-diskretes Signal umgewandelt, welches nur zu ganz bestimmten Zeitpunkten, nur ganz bestimmte Werte aufweisen kann.

Diese Abstufung (Quantisierung) des Betrages in der Zeit wird durch folgende zwei Grössen beschrieben: Abtastrate und Auflösung (Bit-Tiefe).

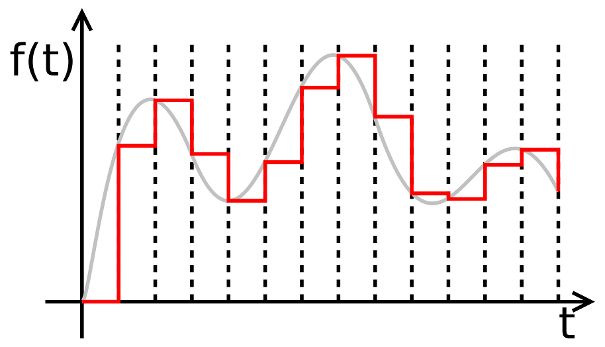

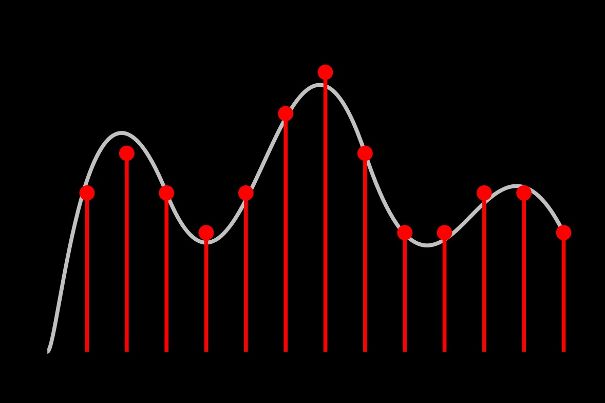

Analog-Digital-Wandlung optisch dargestellt (Quelle: Wikipedia).

Analog-Digital-Wandlung optisch dargestellt (Quelle: Wikipedia).Abtastrate (Sampling Rate)

Die erste Grösse – die Sampling Rate – bezeichnet die Häufigkeit, mit der das analoge Tonsignal abgetastet wird (oder Samples genommen werden, daher «Sampling») und danach in ein zeitdiskretes oder eben digitales Signal umgewandelt wird. Der berühmte Red Book Standard der CD hat 44,100 kHz. Das heisst: Bei der regulären CD wird das Signal 44'100-mal pro Sekunde abgetastet. Es werden also 44'100 Samples genommen, einmal für den rechten und einmal für den linken Kanal (Stereo).

Das Nyquist-Shannon-Abtasttheorem – eine überlange Wortkonstruktion – besagt, dass ein Signal mit mindestens mehr als dem doppelten Intervall seiner maximalen Frequenz abgetastet werden muss, um korrekt rekonstruiert werden zu können. Will man also den Audio-Bereich bis etwa 20’000 Hz rekonstruieren, muss man schneller als 40'000-mal pro Sekunde abtasten. Der CD-Standard mit 44.1 kHz erfüllt diese Forderung somit vollumfänglich.

Im nachfolgenden Video wird dieses Thema erklärt:

Die zweite Grösse, die Bit-Tiefe definiert, wie hoch die Auflösung eines Samples sein kann. Weil das übliche digitale System ein binäres Zahlensystem ist, können mit einem Bit zwei unterschiedliche Zustände dargestellt werden: die berühmten «Einsen oder Nullen». Mit jedem weiteren Bit wird die Anzahl Möglichkeiten verdoppelt. Bei 8 Bit sind es also bereits 256 Möglichkeiten, bei 10 Bit sind es 1024 Möglichkeiten, usw. Diese Zahlen kommen Ihnen aus der Computerwelt sicher bekannt vor und sind tägliches Brot in der Informatik.

Ausgestattet ist der HD 598 mit der identischen, extrem resonazarmen Duofol-Membran, welche auch hier für einen sehr ausgewogenen Klang sorgt. Gemäss Datenblatt soll der HD 598 im Topend des Frequenzbandes noch mehr Auflösung bieten. Im Hörtest liess sich dies im Direktvergleich aber nur erahnen.

Wie schon der HD 558 besticht der HD 598 mit seiner räumliche Auffächerung. Mühelos gelingt ihm eine dreidimensipnale Raumdarstellung - sofern es denn die Aufnahme zulässt. Egal, ob bei einer Jazz-Combo oder einem grossen Symphonieorchester, der Raumeindruck kommt wunderbar zur Geltung. Alles klingt weit und gross, plötzlich lassen sich auch sonst leicht verdeckte Instrumente spielend lokalisieren.

Quantisierungsfehler aufgrund der begrenzten Auflösung

So logisch das Ganze klingt, hat die Digitalisierung einige Pferdefüsse- Einer der grössten sind Quantisierungsfehler – einfacher ausgedrückt: Rundungsfehler. Wird nämlich der aktuelle analoge Wert gesampelt, wird diesem Spannungswert ein digitaler Wert zugewiesen. Dieser wird an der letzten digitalen Stelle stets etwas auf- oder abgerundet, mal etwas mehr, mal etwas weniger. Dies ist abhängig davon, wie weit das tatsächliche Signal vom nächsten Schritt entfernt ist.

Den Fehler, welcher dadurch entsteht, nennt man das Quantisierungsrauschen, das also umso geringer ausfällt, je höher die Auflösung ist. Bei 24 Bit ist dieses Quantisierungsrauschen um 48 dB – oder anders ausgedrückt 256-mal niedriger als bei 16 Bit. Auch hier ist der praktische Nutzen weitaus geringer als es die Zahlen erhoffen lassen. Ein paar Bit mehr als 16 Bit bringen aber durchaus nachvollziehbare Verbesserungen, wenn die Aufnahme gut gemacht und die Wiedergabekette konsequent auf hohem Niveau ist. Will heissen: Eine qualitativ gut aufgenommene Aufnahme nach dem Red-Book-Standard kann mit 16 Bit besser klingen als eine weniger gut aufgenommene 24-Bit-HiRes-Aufnahme. Das Tonstudio ist also Herr der (Digital-)Klänge!

Diese Grafik veranschaulicht die Quantisierungsfehler (Quelle: Wikipedia).

Diese Grafik veranschaulicht die Quantisierungsfehler (Quelle: Wikipedia).Ist HiRes besser?

Bei einer höheren Auflösung als 16 Bit und einer Samplerate von mehr als 48 kHz spricht man von High-Resolution Audio, was implizit etwas besonders Gutes suggeriert. Tatsächlich ist HiRes allein jedoch keineswegs ein Prädikat für bessere Aufnahmen (und Wiedergabe). Es scheint Einigkeit zu herrschen, dass es in erster Linie auf völlig andere Faktoren ankommt. Dazu zählen sicherlich die Arbeiten eines erfahrenen Tonmeisters und dass die digitale Kost nicht mit «Geschmacksverstärkern» für zeitgemässe Wiedergabegeräte wie Boom-Boxen, bassschwachen Stöpsel-Kopfhörer und Autoradios abgeschmeckt wird.

Die soeben beschriebenen Systembedingungen und weitere Fehler in der nicht idealen Verarbeitung führen zu Abweichungen zwischen dem originalen Analogsignal zum rekonstruierten Digitalsignal.

Ein interessantes psychoakustisches Phänomen sei hier noch am Rande erwähnt. Die Wissenschaft geht davon aus, dass das Amplitudenauflösungsvermögen (grässliches Wort mit 28 Buchstaben) sensationelle 1 Million Abstufungen zulässt. So kann es noch Lautstärkeunterschiede von sagenhaften 0,0001 dB unterscheiden, was in etwa einem 20-22-Bit-Digitalsystem entspricht. Dies würde meiner Meinung nach unter anderem auch erklären, dass der Mensch sehr sensibel auf Fehler bei der Wiedergabe von digital aufbereiteten Signalen reagiert. Echt beeindruckend!

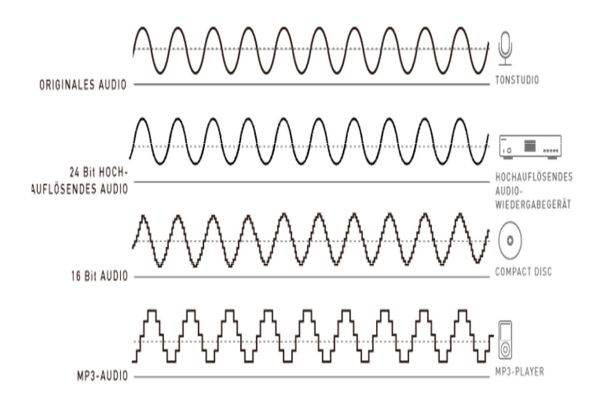

Die Unterschiede der Digitalformate gut veranschaulicht.

Die Unterschiede der Digitalformate gut veranschaulicht.Oversampling

Von Oversampling – auf Deutsch Überabtastung – spricht man, wenn das digitale Signal mit einer höheren Abtastrate bearbeitet wird, als für die Darstellung der Signalbandbreite eigentlich nötig wäre. Beim Audio-CD-Standard Red Book also mit einem Vielfachen der Abtastfrequenz von 44,1 kHz.

Durch das Oversampling gibt es weniger Störleistung im nutzbaren Audioband. Innerhalb der gleichen Bandbreite verringert sich der Störpegel bei jeder Verdoppelung der Sampling-Frequenz um 3dB.

Bei Oversampling-Prozessen müssen aber zwingend digitale Filter eingesetzt werden, die ihrerseits auch neue Effekte schaffen. Einer dieser Effekte ist das Pre- und Post-Ringing, ein durch den Filter verursachtes Verschmieren. Dieses Phänomen äussert sich klanglich in eingeengter Räumlichkeit, harten Klangtexturen und möglicherweise übertriebener Brillanz.

Multi-Bit vs. Sigma-Delta-Verfahren

Beim Sigma-Delta-Verfahren wird die Idee des eben beschriebenen Oversamplings weitergeführt. Es wird mit dem 64-Fachen der Standard-Abtastfrequenz gearbeitet (64 x 44,1 kHz = 2,8224 Mhz). Das Sigma-Delta-Verfahren ist heute der meistverbreitete A-D/D-A-Prozess.

Die Vorteile der modernen Techniken wie Oversampling und Sigma-Delta-Verfahren sind vorwiegend in der einfacheren technischen Umsetzung, simpler Integration sowie Miniaturisierung und massiv niedrigeren Kosten zu begründen. Multi-Bit und Non-Oversampling-Konzepte (NOS-Wandler) sind deutlich aufwendiger, anfälliger auf Systembedingungen und kostspieliger, überzeugen dafür aber mit organischem, authentischem Klang, wenn sie denn gut umgesetzt sind (was leider oftmals nicht der Fall ist). Sind NOS-Wandler nur mittelmässig umgesetzt, überzeugen sie zwar häufig mit sehr angenehmem und stressfreiem Klang, tönen aber auch etwas romantisch, zu wenig klar und nicht präzise genug. Empfindliche Hörer, die vorwiegend akustische Musik hören und allergisch auf «Digitalklang» reagieren, ziehen einen euphonischen NOS-Wandler meist eindeutig vor.

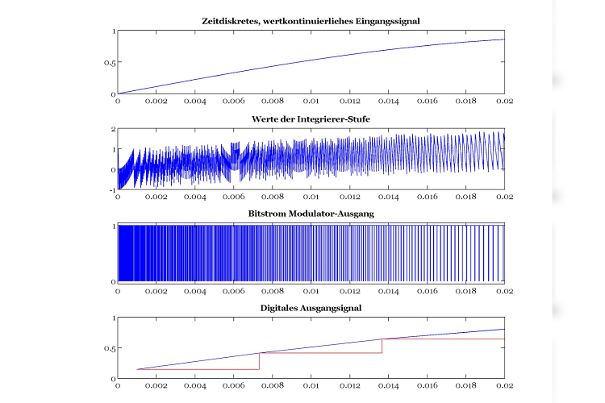

Werte in verschiedenen Stufen des Delta-Sigma-Umsetzers (Quelle: Wikipedia).

Werte in verschiedenen Stufen des Delta-Sigma-Umsetzers (Quelle: Wikipedia).

Alle Themen

Alle Themen